2024 年 8 月,LinkedIn 的一篇帖子引起了人们的警惕,该帖子声称 ChatGPT(以及与之相关的 Microsoft Copilot)能够访问私有 GitHub 存储库中的数据。如果这一说法属实,可能会对数据安全和隐私产生重大影响。

为了查明这一说法背后的真相,数字安全公司Lasso的研究团队进行了彻底的调查。他们发现了一个数字难题,涉及缓存、公开暴露的数据,现在又涉及到私人数据——他们将这种现象称为“僵尸数据”。

开始调查

调查始于 LinkedIn 帖子,该帖子暗示 ChatGPT 可能利用已设为私有的 GitHub 存储库中的数据。Lasso 的团队进行了快速搜索,发现有问题的存储库在公开阶段已被 Bing 编入索引,但已无法在 GitHub 上直接访问。

当向 ChatGPT 查询存储库时,很明显 AI 工具不是从直接访问中提取数据,而是从假设或索引内容中提取数据。正如 Lasso 指出的那样,ChatGPT 在制作回复时依赖 Bing 进行网络索引,这提供了一种解释:曾经公开但后来变为私有的存储库的索引数据被 Bing 的缓存捕获。

然而,这一发现引发了两个迫切的问题:被设为私有或删除的存储库中的数据会怎样?还有多少其他存储库可能受到这种现象的影响?

近在咫尺的发现

作为调查的一部分,Lasso 决定测试他们自己的系统。快速的 Bing 搜索显示,他们的一个组织存储库尽管在 GitHub 上被设为私密,但仍被编入索引。内部审计表明,这个存储库在被保护之前曾被错误地公开了一小段时间。

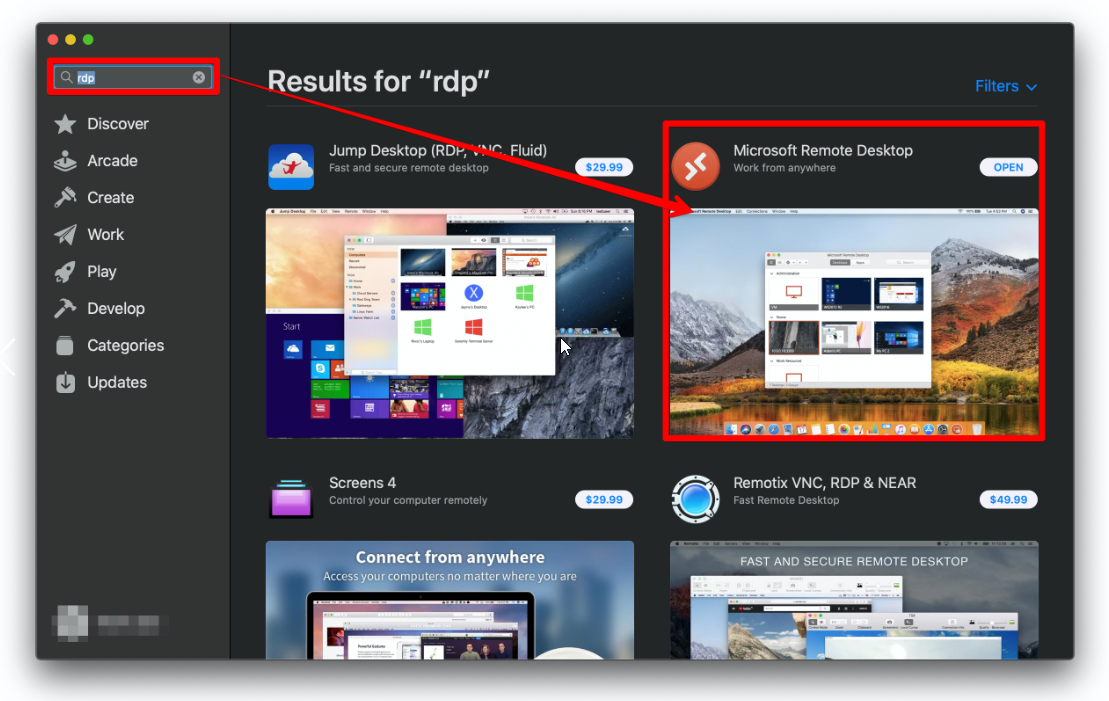

为了测试缓存数据是否可检索,该团队对 ChatGPT 进行了探索。虽然 ChatGPT 只能通过 Bing 的缓存推断存储库的存在,但它并没有提供可操作的数据。然而,微软的另一款 AI 工具 Copilot 却给出了更令人担忧的结果。

与 ChatGPT 不同,Microsoft Copilot 能够从存储库公开时提取实际数据。这表明 Copilot 正在访问存储库内容的缓存快照 – 即上述“僵尸数据”,这些信息用户认为是私密的或已删除的,但如果被外部工具或系统缓存,仍然可以访问。

Microsoft Copilot 强调“僵尸数据”的风险

这一发现引发了人们对 GitHub 等无处不在的平台上的数据隐私的严重质疑。发现的关键问题包括:

- “僵尸数据”持久性:暂时公开的数据可以通过 Bing 等缓存无限期地检索,即使设置为私有也是如此。用 Lasso 的话来说:“任何公开的信息,即使是短暂公开,都可以被 Microsoft Copilot 访问和分发。”

- 私有代码面临风险:存储在存储库中的敏感组织数据(尤其是在保护之前意外公开的数据)尤其面临风险。这些存储库可能包含可能被利用的凭证、令牌和其他关键资产。

- 微软的作用: Microsoft Copilot 能够通过 Bing 访问缓存快照,这让问题变得更加严重。这种联系引发了人们对这家科技巨头开发的工具是否能够充分处理用户安全问题的质疑,尤其是考虑到 GitHub、Bing 和 Copilot 都是微软生态系统的一部分。

系统调查发现广泛暴露

Lasso 使用 Google BigQuery 的 GitHub 活动数据集,编制了一份 2024 年期间某个时间点曾公开但现在已设置为私有的所有存储库列表。

他们的研究工作流程包括以下步骤:

- 识别公共活动:他们隔离了那些曾经是公共的但由于删除或设置为私有而无法再访问的存储库。

- 探测 Bing 的缓存:对于每个标记为“丢失”的存储库,团队都会使用 Bing 搜索与存储库相关的缓存记录。

- 扫描暴露的数据:对提取的缓存数据进行分析以获取敏感信息,包括秘密、令牌、密钥和未列出的依赖项。

拉索的发现令人吃惊:

- 超过 20,580 个 GitHub 存储库尽管是私有的或已被删除,但仍被识别为可通过 Bing 的缓存访问。

- 16,290 个组织受到影响,其中包括微软、谷歌、英特尔、华为、PayPal、IBM 和腾讯等主要公司。

- 100 多个易受攻击的软件包和300 多个私人凭证或秘密(针对 GitHub、OpenAI 和 Google Cloud 等平台)被曝光,说明了该问题的严重性。

微软的回应和 Copilot 的部分修复

得知这一发现后,Lasso 联系了微软并报告了该漏洞。尽管微软承认了这一问题,但将其归类为“低严重性”,并称影响有限。尽管如此,该公司还是迅速采取行动来缓解问题。

两周之内,Bing 的缓存链接功能被移除,存储缓存页面的 cc.bingj.com 域名对所有用户禁用。然而,修复只是表面问题。缓存结果继续出现在 Bing 搜索中,最令人担忧的是,Copilot 保留了对人类用户隐藏的敏感数据的访问权限。

2025 年 1 月,在了解到与 TechCrunch 报告相关的 GitHub 存储库后,Lasso 再次测试了这种情况。尽管微软根据法律理由删除了该存储库,但 Copilot 仍然设法检索了其内容——再次证实了人们对 Bing 驱动的系统可能规避人类保护措施的担忧。

研究结果的含义

LLM 的激增为组织数据安全带来了全新的威胁。与传统的泄密或黑客攻击造成的数据泄露不同,Copilot 能够显示缓存的“僵尸数据”,从而暴露出一些组织没有做好准备的漏洞。

根据他们的研究,Lasso 概述了几个关键要点:

- 假设数据一旦公开就会受到损害:组织应该将任何公开的数据视为可能永远受到损害的数据,因为索引引擎或人工智能系统可能会利用这些数据进行未来的训练和检索。

- 不断发展的威胁情报:安全监控应扩展到 LLM 和 AI 副驾驶,以评估他们是否通过宽容的参与暴露敏感数据。

- 执行严格的权限:人工智能系统急于做出响应可能会超越界限,导致过度共享。组织必须确保此类工具遵守严格的权限和访问控制。

- 基础卫生仍然很重要:尽管风险层出不穷,但基本的网络卫生实践仍然至关重要。保持敏感存储库的私密性、避免硬编码令牌以及通过官方存储库保护内部软件包都是必不可少措施。

Lasso 的发现以及微软的部分回应凸显了“僵尸数据”带来的持续挑战以及生成式 AI 工具日益增长的影响力。在数据为王、法学硕士是贪婪消费者的时代,组织必须管理离开其网络的每一个字节——一旦离开,可能就再也回不来了。