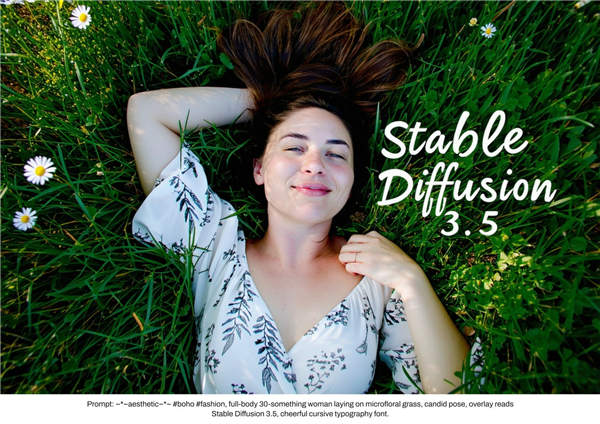

Stability AI宣布发布Stable Diffusion 3.5,标志着开源AI图像生成模型的一次飞跃。

Stability AI 的最新模型包括多种变体,旨在满足从业余爱好者到企业级应用的不同用户需求。

该公司承认,此版本是在 6 月份发布 Stable Diffusion 3 Medium 之后发布的,但发布结果未达到预期。

Stability AI 表示:“此次发布并未完全满足我们的标准或社区的期望。”

Stability AI 表示,他们并没有急于采取快速解决方案,而是投入了时间来开发更为强大的解决方案。

旗舰型号 Stable Diffusion 3.5 Large 拥有 80 亿个参数,分辨率为 100 万像素,是 Stable Diffusion 系列中最强大的型号。此外,Large Turbo 版本也具有同等质量,但仅需四个步骤即可生成图像,从而大大缩短了处理时间。

中型版本计划于 10 月 29 日发布,包含 25 亿个参数,支持 0.25 至 2 百万像素分辨率的图像生成。此版本专门针对消费级硬件进行了优化。

这些模型在 transformer 模块中采用了查询键归一化,提高了训练稳定性并简化了微调过程。然而,这种灵活性是有代价的,包括使用不同种子的相同提示的输出差异更大。

Stability AI 为此次发布实施了非常宽松的社区许可。这些模型可免费用于非商业用途,可供年收入低于 100 万美元的企业使用。超过此门槛的企业必须获得单独的许可安排。

该公司强调了其对负责任的人工智能开发的承诺,从早期阶段就实施了安全措施。计划在 Medium 型号推出后发布其他功能,包括用于高级控制功能的 ControlNets。

Stability AI 的最新图像生成模型目前可通过Hugging Face和GitHub获得,并且还可以通过Stability AI API、Replicate、ComfyUI和 DeepInfra等平台访问。