我们收集了戴尔科技、联想、超微和技嘉的五款超酷人工智能和高性能计算服务器,这些服务器使用 AMD 的 Instinct MI300 芯片,该芯片于几个月前推出,旨在挑战 Nvidia 在人工智能计算领域的主导地位。

AMD 正在凭借其 Instinct MI300 加速器芯片向 Nvidia 在人工智能计算领域的主导地位发起迄今为止最大的挑战。推出几个月后,多款 MI300 服务器现已上市或即将发布,作为采用 Nvidia 流行芯片的系统的替代品。

在周二召开的第一季度财报电话会议上,AMD 董事长兼首席执行官苏姿丰 (Lisa Su) 表示,MI300 在“不到两个季度的总销售额”中就创造了超过 10 亿美元的成绩,成为其历史上“增长最快的产品”。

因此,AMD 目前预计 MI300 今年将产生 40 亿美元的收入,比该公司 1 月份的预测高出 5 亿美元。

“我们现在看到的是现有客户以及承诺使用 MI300 的新客户的可见性更高,”Su 说。

MI300系列目前由两款产品组成:MI300X GPU,配备192 GB HBM3高带宽内存;MI300A APU,在同一台处理器上结合了Zen 4 CPU核心和CDNA 3 GPU核心以及128 GB HBM3内存。死。

这些芯片已应用于戴尔科技、联想、超微和技嘉等主要 OEM 厂商现已推出或即将推出的系统中。

这家总部位于加利福尼亚州圣克拉拉的公司将 MI300X 定位为 Nvidia 流行且功能强大的 H100 数据中心 GPU 的强大竞争对手,用于人工智能训练和推理。例如,该公司表示,与 Nvidia 的 8 个 GPU H100 相比,其 MI300X 平台结合了 8 个 MI300X GPU,为 1760 亿个参数的 Bloom 模型提供了 60% 高的推理吞吐量,为 70B Llama 2 模型提供了 40% 低的聊天延迟GHX 平台。

而MI300A则更针对高性能计算和AI工作负载的融合。对于 64 位浮点计算,AMD 表示 MI300A 比 H100 快 80%。 AMD 表示,与 Nvidia 的 GH200 Grace Hopper Superchip(将 Grace GPU 与 H200 GPU 结合在一起)相比,MI300A 的 HPC 性能提高了两倍。

尽管 AMD 在 MI300 芯片上发现了所有优势,但该公司必须面对这样一个事实:Nvidia 正在加速芯片路线图,并计划在今年晚些时候发布 H100、H200 和 GH200 处理器的后继产品。

在最近的财报电话会议上,Su 表示 AMD 的战略不是关于一种产品,而是关于“多年、多代路线图”,并开玩笑说,它将在“未来几个月”分享有关“今年晚些时候到 2025 年”推出的新加速器芯片的详细信息。

“我们对继续保持竞争力的能力非常有信心。坦率地说,我认为我们将变得更具竞争力,”她说。

以下是来自戴尔、联想、Supermicro 和 Gigabyte 的五款超酷 AI 和 HPC 服务器,它们使用 AMD 的 Instinct MI300X GPU 或 Instinct MI300A APU。

1.戴尔 PowerEdge XE9680

戴尔的 PowerEdge XE9680 是一款风冷 6U 服务器,旨在为最复杂的生成式 AI、机器学习、深度学习和高性能计算工作负载提供支持。

该服务器使用 AMD Infinity Fabric 连接八个 AMD Instinct MI300X GPU,为系统提供 1.5 TB HBM3 高带宽内存和超过 21 petaflops 的 16 位浮点 (FP16) 性能。该系统通过 32 个 DIMM 插槽支持最大 4 TB DDR5 内存,并配备多达 10 个 PCIe Gen 5 扩展插槽。

PowerEdge XE9680 预计将于今年夏天上市,其主机处理器是两个第四代 Intel Xeon 可扩展 CPU,每个处理器最多可提供 56 个内核。

该服务器最多支持 8 个 2.5 英寸 NVMe/SAS/SATA SSD 驱动器,总计 122.88 TB;最多支持 16 个 E3.S NVMe 直连驱动器,总计 122.88 TB。

PowerEdge XE9680 配备了 Dell OpenManage 系统管理软件产品组合以及基于硅的信任根等安全功能。

2.联想ThinkSystem SR685a V3

联想最近推出的ThinkSystem SR685a V3是一款风冷8U服务器,旨在处理要求最苛刻的人工智能工作负载,例如大型语言模型。

该服务器现已上市,使用 AMD Infinity Fabric 连接八个 AMD Instinct MI300X GPU,为其提供 1.5 TB HBM3 高带宽内存容量和高达 1 TBps 的峰值聚合 I/O 带宽。它还通过 24 个 DIMM 插槽支持高达 3 TB 的 DDR5 内存,并配有多达 10 个用于连接扩展卡的 PCIe Gen 5 插槽。

ThinkSystem SR685a V3 还与 Nvidia 的 H100 和 H200 GPU 以及芯片设计商即将推出的 B100 GPU 兼容。

据OEM称,该服务器的主机处理器是两个第四代AMD EPYC CPU,可以升级到下一代服务器芯片。

最多支持16个2.5英寸热插拔NVMe SSD。它还配备了两个 M.2 启动驱动器。

联想表示,其空气冷却设计提供了“巨大的热空间”,使 GPU 和 CPU 能够提供持续的最高性能。

该服务器配备了 Lenovo 的 XClarity 系统管理软件。

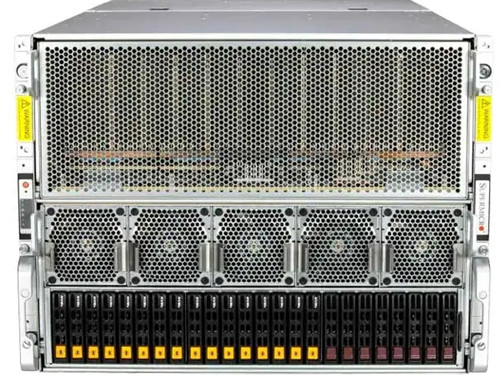

3.超微 AS-8125GS-TNMR2

Supermicro 的 AS-8125GS-TNMR2 是一款风冷 8U 服务器,旨在消除大型语言模型的 AI 训练瓶颈,并作为大规模训练集群的一部分。

该服务器现已上市,使用 AMD Infinity Fabric 连接八个 AMD Instinct MI300X GPU,使其能够提供 1.5 TB 的 HBM3 高带宽内存池。这是对 24 个 DIMM 插槽支持的最大 6 TB DDR5 内存的补充。

AS-8125GS-TNMR2 配备 8 个 PCIe Gen 5 薄型扩展插槽,可实现 8 个 400G 网卡和 8 个 GPU 之间的直接连接,以支持大规模集群。它还具有两个 PCIe Gen 5 全高、全长扩展插槽。

主机处理器是两个第四代 AMD EPYC CPU,每个处理器最多支持 128 个内核。

它配备 12 个 PCIe Gen 5 NVMe U.2 驱动器,还可以选择四个附加驱动器、两个热插拔 2.5 英寸 SATA 驱动器和两个 M.2 NVMe 启动驱动器。

其他功能包括内置服务器管理工具、Supermicro SuperCloud Composer、Supermicro Server Manager 和硬件信任根。

4.技嘉G593-ZX1

技嘉G593-ZX1是一款风冷5U服务器,专为人工智能训练和推理而设计,特别是在涉及大型语言模型和其他类型的海量人工智能模型时。

该服务器使用AMD Infinity Fabric连接八个AMD Instinct MI300X GPU,使其能够提供1.5 TB的HBM3高带宽内存和42.4 TBps的峰值理论聚合内存带宽。它还支持 24 个 DDR5 内存 DIMM,并配有 12 个用于 GPU、网卡或存储设备的 PCIe Gen 5 扩展插槽。

G593-ZX1 的主机处理器是两个第四代 AMD EPYC CPU。

它支持八个2.5英寸NVMe/SATA/SAS-4热插拔驱动器。

该服务器的功能包括驱动器托架的免工具设计、可选的 TPM 2.0 模块、智能穿越、智能危机管理和保护以及双 ROM 架构。

预计将于今年上半年上市。

5.Supermicro AS-2145GH-TNMR

Supermicro 的 AS-2145GH-TNMR 是一款液冷 2U 服务器,旨在加速高性能计算工作负载。

该服务器现已上市,配备四个 AMD Instinct MI300A 加速器,每个加速器在同一芯片封装上结合了 Zen 4 CPU 和 CDNA 3 GPU 内核以及 HBM3 内存,以打破 CPU-GPU 通信的传统瓶颈。每个芯片上配备128GB HBM3高带宽内存,系统总共提供512GB内存。

AS-2145GH-TNMR 支持八个 2.5 英寸 US NVMe 热插拔驱动器选件。它还配备了两个 M.2 NVMe 启动驱动器。

Supermicro表示,与风冷解决方案相比,该服务器的直接芯片定制液体冷却技术使数据中心运营商能够将总拥有成本降低51%以上。它还使粉丝数量减少了 70%。

AS-2145GH-TNMR 配备两个紧凑型 PCIe Gen 5 AIOM 插槽和八个 PCIe Gen 5 x 16 插槽,支持超级计算集群的 400G 以太网 InfiniBand 网络。

其他功能包括内置服务器管理工具、Supermicro SuperCloud Composer、Supermicro Server Manager 和 SuperDoctor 5。